Le buzz constant autour du ChatGPT d'OpenAI refuse de s'estomper. Étant donné que Microsoft utilise désormais la même technologie pour alimenter son tout nouveau Bing Chat , il est prudent de dire que ChatGPT pourrait poursuivre cette tendance à la hausse pendant un certain temps. C'est une bonne nouvelle pour OpenAI et Microsoft, mais ce ne sont pas les deux seules entreprises à en bénéficier.

Selon un nouveau rapport, les ventes des cartes graphiques de centre de données de Nvidia pourraient être sur le point de monter en flèche. Avec la commercialisation de ChatGPT, Avec la mise en vente de ChatGPT, OpenAI pourrait nécessiter jusqu'à 10 000 nouveaux GPU pour soutenir la croissance continue de son modèle - et Nvidia semble être le fournisseur le plus probable.

"Le nombre de paramètres de formation utilisés dans le développement de ce modèle de langage autorégressif est passé d'environ 120 millions en 2018 à près de 180 milliards en 2020", a déclaré TrendForce dans son rapport. Bien qu'il n'ait partagé aucune estimation pour 2023, il est prudent de supposer que ces chiffres ne continueront d'augmenter que dans la mesure où la technologie et le budget le permettront.

La société affirme que le modèle GPT avait besoin de 20 000 cartes graphiques pour traiter les données de formation en 2020. Au fur et à mesure de son expansion, ce nombre devrait dépasser les 30 000. Cela pourrait être une excellente nouvelle pour Nvidia.

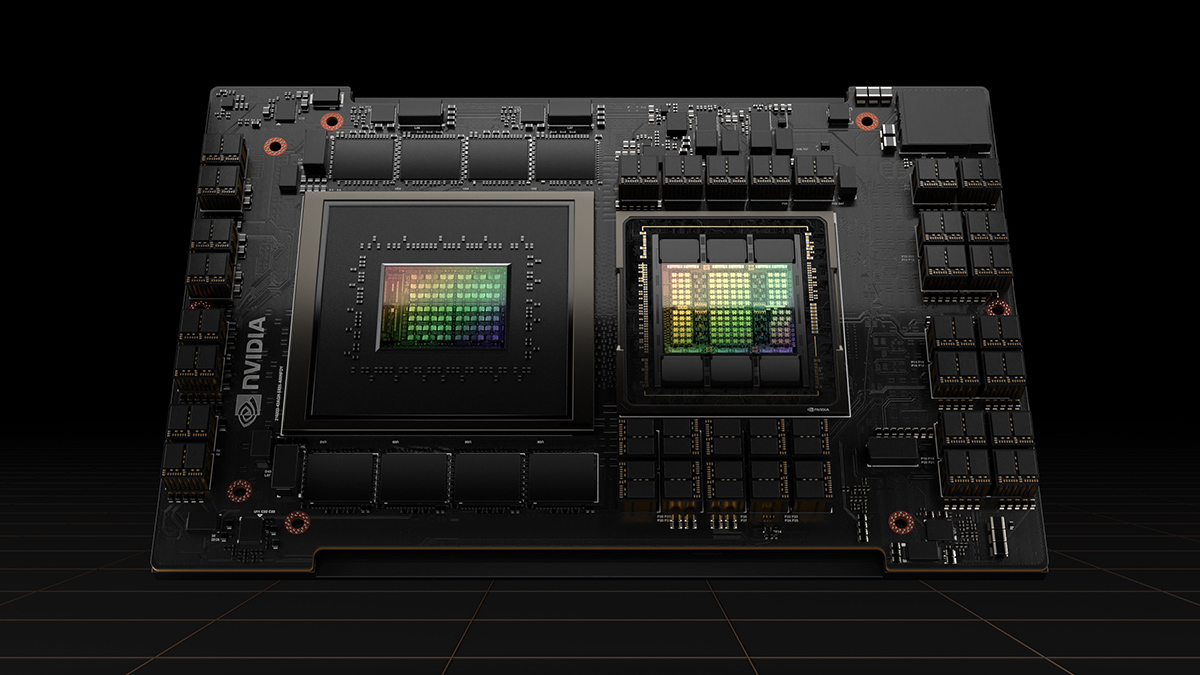

Ces calculs sont basés sur l'hypothèse qu'OpenAI utiliserait les GPU A100 de Nvidia afin d'alimenter le modèle de langage. Ces cartes graphiques ultrapuissantes sont vraiment chères – entre 10 000 $ et 15 000 $ chacune. Ce ne sont pas non plus les meilleures cartes de centre de données de Nvidia à l'heure actuelle, il est donc possible qu'OpenAI opte plutôt pour les nouvelles cartes H100, qui sont censées offrir jusqu'à trois fois les performances de l'A100. Ces GPU s'accompagnent d'une forte augmentation de prix, une carte coûtant environ 30 000 $ ou plus.

Le marché des GPU des centres de données ne se compose pas uniquement de Nvidia - Intel et AMD vendent également des accélérateurs d'IA. Toutefois, Nvidia est souvent considérée comme la solution incontournable pour les tâches liées à l'IA, ce qui lui permettrait de conclure un accord lucratif si et quand OpenAI décide de se développer.

Les joueurs devraient-ils s'inquiéter si Nvidia finit par fournir 10 000 GPU pour alimenter ChatGPT ? Ça dépend. Les cartes graphiques requises par OpenAI n'ont rien à voir avec les meilleurs GPU de Nvidia pour les joueurs, nous y sommes donc en sécurité. Cependant, si Nvidia transfère une partie de sa production vers les GPU des centres de données, cela pourrait entraîner une offre limitée de cartes graphiques grand public sur toute la ligne. De manière réaliste, l'impact n'est peut-être pas si grave - même si la prédiction de 10 000 GPU se vérifie, Nvidia n'aura pas besoin de les livrer tous tout de suite.

إرسال تعليق